|

Posted: 29 Apr 2013 08:35 AM PDT

Referencia: News.Discovery.com .

por Jesse Emspak, LiveScience, 28 de abril 2013

La velocidad de la luz es constante, al menos eso es lo que dicen los libros de texto. Sin embargo, algunos científicos están explorando la posibilidad de que haya cambios cósmicos en este límite de velocidad, como consecuencia de la naturaleza del vacío del espacio. La definición de la velocidad de la luz tiene consecuencias muy importantes para la cosmología y la astronomía, las cuales asumen una velocidad estable de la luz con el tiempo. Por ejemplo, la velocidad de la luz proviene de la medición de laconstante de estructura fina (alfa), que define la intensidad de la fuerza electromagnética. Y una velocidad de la luz variable cambiaría las fuerzas de los enlaces moleculares y la densidad de la materia nuclear misma. Una velocidad no constante de la luz podría significar que las estimaciones del tamaño del universo pueden estar equivocadas. (Por desgracia, no necesariamente significa que se pueda viajar más rápido que la luz, porque los efectos de las teorías físicas, como la relatividad, son una consecuencia de la velocidad de la luz). Dos artículos, publicados en el journal Europeo de Física en marzo, intentan obtener la velocidad de la luz a partir de las propiedades cuánticas del mismo espacio. Ambos proponen mecanismos un tanto diferentes, pero la idea es que la velocidad de la luz podría cambiar a medida que se suponen alteraciones acerca de cómo las partículas elementales interactúan con la radiación. Ya se trate de un espacio que no está vacío, aunque haya una gran gran sopa de partículas virtuales que guiñan saltando dentro y fuera de la existencia en pequeñas fracciones de segundo. Vacío cósmico y velocidad de la luz El autor principal Marcel Urban de la Université du Paris-Sud, ve en el vacío cósmico, lo que a menudo se supone que es el espacio vacío. Las leyes de la física cuántica, que rigen las partículas subatómicas y todas las cosas muy pequeñas, dicen que el vacío del espacio está en realidad lleno de partículas fundamentales como los quarks, las llamados partículas "virtuales". Estas partículas de materia, siempre emparejadas con su pertinente antipartícula, asoman a la existencia y chocan casi de inmediato. Cuando las partículas de materia y antimateria se ponen en contacto, se aniquilan entre sí. Los fotones de luz, mientras viajan por el espacio, son capturados y re-emitidos por estas partículas virtuales. Urban y sus colegas, proponen que las energías de estas partículas, en concreto la cantidad de carga que acarrean, afectan a la velocidad de la luz. Puesto que la cantidad de energía que tenga una partícula en ese momento golpeará al fotón de forma esencialmente aleatoria, el efecto sobre la velocidad de movimiento de los fotones podrá variar bastante. En tal situación, la cantidad de veces que la luz necesita para cruzar una distancia dada debe variar como la raíz cuadrada de la distancia, aunque el efecto sería muy pequeño, puede que del orden de 0,05 femtosegundos por cada metro cuadrado de vacío. Un femtosegundo es una millonésima de una mil millonésima de segundo. La velocidad de la luz se ha medido en el último siglo con alta precisión, del orden de pocas partes por mil millones, por lo que está bastante claro que el efecto tiene que ser pequeño. Para encontrar esta pequeña fluctuación, según los investigadores, se podría medir cómo se dispersa la luz a grandes distancias. Algunos fenómenos astronómicos, como las explosiones de rayos gamma, producen pulsos de radiación lo suficientemente lejos para que dichas fluctuaciones pueden ser detectadas. Los autores también proponen el uso de láseres que reboten entre espejos colocados a unos 100 metros de distancia, junto a un haz de luz que rebota entre ellos múltiples veces, a fin de localizar esos pequeños cambios. Especies de partículas y velocidad de la luz En el segundo artículo se propone un mecanismo diferente, aunque llega a la misma conclusión de los cambios en la velocidad de luz. En ese caso, Gerd Leuchs y Luis Sánchez-Soto, del Instituto Max Planck de Física de la Luz en Erlangen, Alemania, afirma que el número de especies de partícula elementales que existe en el universo puede ser lo que hace que la velocidad de la luz sea lo que es. Leuchs y Sánchez-Soto dicen que debe haber, según sus cálculos, del orden de 100 "especies" de partículas con carga. La actual ley que rige en materia de física de partículas, el Modelo Estándar, identifica nueve: electrón, muón, tauon, los seis tipos de quarks, fotones y el bosón W. La carga de todas estas partículas es importante para su modelo, ya que todas ellas están cargadas. Una cantidad, llamada impedancia, depende de la suma de esas cargas. La impedancia a su vez depende de la permitividad del vacío, o de cuánto se resiste a los campos eléctricos, así como su permeabilidad, o cómo soporta los campos magnéticos. Las ondas de luz están compuestas tanto de onda eléctrica como magnética, así que cambiar esas cantidades (permitividad ypermeabilidad) cambiaría la medición de la velocidad de la luz. "Hemos calculado la permitividad y la permeabilidad del vacío como la causada por esas efímeras virtuales y inestables partículas elementales", escribía Soto-Sánchez. "Y resulta, que a partir de un modelo tan sencillo se puede discernir que esas constantes contienen esencialmente contribuciones equivalentes de los diferentes tipos de pares de partícula-antipartícula cargadas eléctricamente: tanto de las conocidas como de las hasta ahora desconocidas para nosotros." Ambos artículos dicen que la luz interactúa con pares virtuales de partícula-antipartícula. En el modelo de Leuchs y de Sánchez-Soto, la impedancia del vacío (la cual podría acelerar o reducir la velocidad de la luz) depende de la densidad de las partículas. La impedancia hace referencia a la ratio de los campos eléctricos y los campos magnéticos de la luz; cada onda de luz se compone de dos tipos de campo, y su valor medido, junto con la permitividad del espacio a los campos magnéticos, gobierna la velocidad de la luz. Algunos científicos son un poco escépticos. Jay Wacker, un físico de partículas en el Laboratorio del Acelerador Nacional SLAC, dijo que no estaba seguro acerca de que las técnicas matemáticas utilizadas, y que parecía que en ambos casos los científicos no estaban aplicando las herramientas matemáticas de una forma adecuada. "La forma correcta de hacer esto es con los diagramas de Feynman", dijo Wacker. "Es una interesante cuestión (la velocidad de la luz)", agregó, pero los métodos utilizados en estos documentos probablemente no son suficientes para investigarlo. La otra cuestión es que si en realidad hay un montón de otras partículas más allá de las reconocidas por el modelo estándar, entonces esta teoría necesita una revisión seria. Pero hasta ahora, sus predicciones han aguantado, en particular, con el descubrimiento del bosón de Higgs. Esto no significa que no haya más partículas que puedan encontrarse, pero es posible que actualmente esas energías sean alcanzables con los aceleradores de partículas, y aunque sean muy pesadas, es posible que sus efectos se hayan demostrado en otros lugares . - Imagen: Algunos científicos están explorando la posibilidad de que existan cambios en el límite de velocidad cósmica. iStock. - Derechos reservados de LiveScience 2013.

Fuente: Pedro Donaire, BITNAVEGANTES

|

lunes, 29 de abril de 2013

29 Apr 2013

The liquid helium coolant that enabled instruments on board the Herschel space observatory to collect extraordinary images and spectra has finally run out. Launched in 2009, the ESA mission collected unprecedented data of the cool as well as of the distant Universe. Herschel's observations have exceeded expectations, enabling scientists to learn more about how stars form, about the rates of star formation in galaxies across the cosmos, and about the origin and presence of water in different celestial bodies. While observations have come to an end and the spacecraft is to be propelled to a stable parking orbit around the Sun, where it will remain indefinitely, the science mission will continue for several years with many discoveries still to be made in the treasure trove of images and spectra collected by the observatory.

Herschel cooling system and build up. Credit: ESA/AOES Medialab (Click here for further details about this animation.)

|

Observations on ESA's Herschel space observatory ceased on 29 April 2013, as the supply of liquid helium coolant on board the spacecraft had completely evaporated. The most powerful infrared telescope ever flown in space, Herschel operated at far-infrared and sub-millimetre wavelengths, being sensitive to a wide range of low temperatures from a few hundred to less than ten degrees above absolute zero.

"To observe very cold regions with high sensitivity, Herschel's instruments needed to be at even lower temperatures – only a few degrees above absolute zero," explains Thomas Passvogel, Head of the Projects Department in ESA's Directorate of Science and Robotic Exploration, and former Herschel and Planck Programme Manager. "This was achieved through the use of 2300 litres of superfluid helium, which granted us over three and a half years of observations of the cool and distant Universe," he adds.

"Herschel's observations have revealed the cosmos in unprecedented detail at these wavelengths," comments Göran Pilbratt, Herschel Project Scientist at ESA. "We have very exciting results from the observatory's first few years and we are looking forward to many more exciting discoveries," he adds.

|

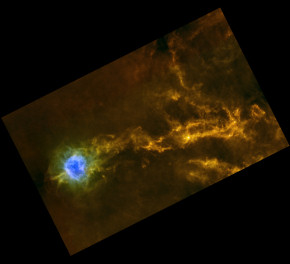

The Cygnus X star-forming complex. Credit: ESA/PACS/SPIRE/Martin Hennemann & Frédérique Motte, Laboratoire AIM Paris-Saclay, CEA/Irfu - CNRS/INSU - Univ. Paris Diderot, France

|

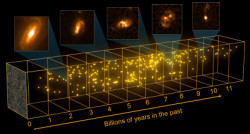

Spanning 12 billion years of star formation in the Universe

Herschel's chief goal is the study of star formation throughout the cosmos, so astronomers have used it to survey thousands of galaxies across a wide span of the Universe's history. These data revealed that galaxies in the first few billion years of cosmic history contributed many more stars than had been previously estimated using observations at shorter or longer wavelengths.

|

A new census of starburst galaxies across the Universe.

Credit: ESA - C. Carreau/C. Casey (University of Hawai'i); COSMOS field: ESA/Herschel/SPIRE/HerMES Key Programme; Hubble images: NASA, ESA |

"Herschel has allowed us to see for the first time a huge population of intensively star-forming galaxies that make up about half of the entire star formation budget of the Universe," comments Matt Griffin from Cardiff University, UK, who is the Principal Investigator of the Spectral and Photometric Imaging Receiver (SPIRE) on board Herschel. "This highlights the importance of looking at the distant Universe in the spectral range covered by Herschel. Stars form in clouds of gas and dust, and most of the energy released by forming stars is absorbed by the dust grains, causing them to warm up. We can detect this warm dust with Herschel and so measure the energy produced by the young stars."

Previous studies hinted that the high star-forming rate of galaxies in the past may be due to episodes of intense star formation, possibly triggered by mergers between massive galaxies. But Herschel has caused a re-think.

"Herschel data suggest that mergers may not be required to generate intense star formation as previously thought. The crucial point appears to be the availability of sufficient gas to make stars. Massively star-forming galaxies could be fed by gas-rich mergers, but also by other processes such as intergalactic streams of cold gas," explains Pilbratt. "The issue remains open, but further analysis of Herschel data along with follow-up observations of these galaxies with other telescopes will hold the key," he adds.

Another study based on Herschel data has assessed that these prolific galaxies can only form in the most massive haloes of dark matter – those with a mass as large as 300 billion times the mass of the Sun. Numerical simulations suggested to astronomers that galaxies take shape in the densest knots of the cosmic web – the wispy network of dark matter throughout the Universe. Herschel has allowed them to measure the mass threshold for the cradles where the most productive galaxies can form, which may be linked to the physical processes triggering the intense star-forming activity of these galaxies.

The change in star formation rates over time may also be linked to the supermassive black hole assumed to exist at the centre of most galaxies. In so-called active galaxies, the central black hole feeds on the surrounding matter at extraordinarily high rates. The radiation pressure created by this accretion triggers an outflow of material, which may drain the galaxy's reservoir of gas and quench its star formation.

"By monitoring a number of relatively nearby active galaxies with Herschel, we have detected, for the first time, vast amounts of outflowing gas that is molecular in nature," comments Albrecht Poglitsch from the Max-Planck-Institut für Extraterrestrische Physik, Germany, who is Principal Investigator of the Photodetector Array Camera and Spectrometer (PACS) on board Herschel. "This shows us that these outflows may indeed deplete a galaxy's supply to form stars, since it is from molecular gas that stars are made," he adds.

Astronomers have used Herschel's galaxy surveys, along with observations at other wavelengths, to search for a direct link between star formation and the activity of the central black hole in large samples of more distant galaxies. But these investigations have led to a variety of different results, indicating that more research will be needed to solve this particular puzzle.

Delving deep into the formation of stars and planetary systems in the Milky Way

|

Dark cloud in the Southern Cross not so dark. Credit: ESA and the SPIRE & PACS consortium

|

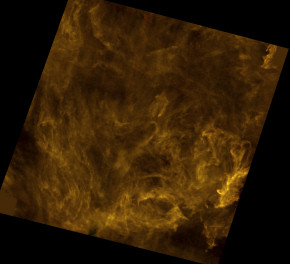

Observations closer to home, in our Galaxy, the Milky Way, yielded extraordinary revelations about the physical processes that give birth to stars. Herschel identified the presence of a filamentary network nearly everywhere in the interstellar medium that pervades the plane of our Galaxy, filaments which lead to the formation of stars.

"We did expect that there would be filaments in the interstellar medium, but Herschel finally gave us proof that they are omnipresent and that they are key to allowing star formation to occur," explains Matt Griffin. "Herschel's beautifully detailed images show how some clouds have developed filaments so dense that they are collapsing under their own weight and starting to form stars, while other clouds exhibit a more chaotic tangle of more tenuous filaments and are not dense enough to form stars – at least, not yet," he adds.

The emergence of filaments and their subsequent collapse into stars may also be linked to magnetic fields in interstellar clouds; Herschel's results have prompted further research into the role of magnetic fields in star formation, which can no longer be neglected.

|

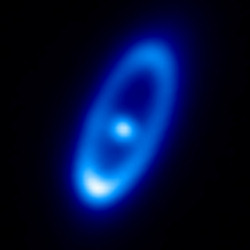

Herschel image of the star Fomalhaut and its debris disc.Credit:ESA/Herschel/PACS/ Bram Acke, KU Leuven, Belgium

|

Herschel has given a unique view of the subsequent stages in the formation of stars, and possibly of planetary systems around them. The image of a massive debris disc around nearby star Fomalhaut suggests a resemblance between this structure and the Kuiper belt as it may have appeared in the early days of our Solar System. The vast amount of dust in Fomalhaut's debris disc is produced by frequent collisions between comets within the disc. Herschel has detected more debris discs around other nearby stars, some of which host planets: a closer inspection of these data hints that debris discs may survive more easily in planetary systems without very massive planets like Jupiter.

"The study of extra-solar debris discs is providing us with new clues to the formation of planetary systems, and may eventually help us to achieve a more complete view of how our own Solar System formed and evolved from its parent cloud," says Albrecht Poglitsch.

Investigating the origin of water in planetary systems

Another highlight from Herschel is the study of the chemical composition of cosmic objects through high-resolution spectroscopy, and in particular the search for water in a variety of environments.

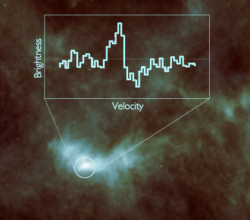

|

Water in L1544. Credit: ESA/Herschel/ SPIRE/HIFI/Caselli et al.

|

Studies based on Herschel data have indicated that a cold pre-stellar core in the vast Taurus molecular cloud hosts a reservoir of water ice amounting to a few million times the amount of water stored in Earth's oceans, and that the massive protoplanetary disc surrounding nearby star TW Hydrae contains a water vapour supply equivalent to several thousand times Earth's oceans.

"These results show that there is plenty of water available to enrich the surface of future planets, should they form in similar discs around stars other than the Sun," says Frank Helmich from SRON Netherlands Institute for Space Research, the Netherlands, who is the Principal Investigator of the Heterodyne Instrument for the Far Infrared (HIFI) on board Herschel.

|

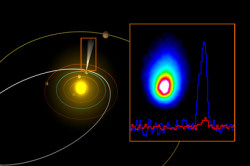

Herschel image and spectrum of comet 103P/Hartley 2 and its orbit.

Credit: ESA/AOES Medialab; Herschel/HssO Consortium |

Herschel has also contributed to the debate about the origin of water in the Solar System, and on Earth in particular. Astronomers believe that water was not present on the surface of our planet during its early days, but was brought here by comets and asteroids which stored water as ice. Asteroids were considered to be the primary source, but the case for comets strengthened after Herschel detected water in comet 103P/Hartley 2 with the same isotopic composition as Earth's oceans. Later observations of comet C/2009 P1 Garradd from Herschel found a different isotopic composition so the role of comets is still uncertain.

"The comparison between the composition of water in comets and on Earth's oceans may have far-reaching implications: if comets did contribute to enriching our planet with water, they might also be responsible for the delivery of other species, such as the carbon- and nitrogen-based compounds that are of great importance to the emergence of life," explains Helmich.

A peek at the future

Astronomers worldwide have so far used Herschel data to produce over 600 scientific papers published in refereed journals. But this is only the beginning: the careful analysis of Herschel's images and spectra will generate many more science discoveries and new insights for years to come.

"While the observations have ceased and the spacecraft will soon be propelled to a stable orbit around the Sun where it will remain indefinitely, Herschel as a science mission is by no means over," comments Pilbratt. "Most of Herschel's data are publicly available already. We will continue supporting the community exploiting the data, collecting and producing the best possible data products in the form of maps, spectra, and various catalogues to benefit all astronomers working with Herschel. We are looking forward to the multitude of great discoveries that are still ahead of us."

Notes for editors

Herschel is an ESA space observatory sensitive to far-infrared and sub-millimetre wavelengths, with science instruments provided by European-led Principal Investigator consortia and with important participation from NASA. Launched on 14 May 2009, Herschel is equipped with a primary mirror 3.5 m across, making it the largest, most powerful infrared telescope ever flown in space.

Its payload consists of three instruments: the Photodetector Array Camera and Spectrometer (PACS), the Spectral and Photometric Imaging Receiver (SPIRE), and the Heterodyne Instrument for the Far Infrared (HIFI). All three instruments were cooled to -271°C inside a cryostat filled with 2300 litres of liquid superfluid helium, which weighed 335 kg – nearly 10 percent of Herschel's mass at launch. After almost four years of observations, the mission finally exhausted its coolant today.

Herschel has executed over 35 000 scientific observations, amassing more than 25 000 hours worth of science data from about 600 observing programmes. A further 2000 hours of calibration observations also contribute to the rich dataset.

Herschel will continue communicating with its ground stations for a few weeks after the helium is exhausted, during which a range of technical tests will be performed. Finally, in May, it will be propelled into its long-term stable orbit around the Sun, where it will remain indefinitely, and safe from Earth impact for several hundreds of years.

The PACS instrument contains an imaging photometer (camera) and an imaging spectrometer. The camera operates in three bands centred on 70, 100, and 160 μm, respectively, and the spectrometer covers the wavelength range between 51 and 220 μm. PACS has been developed by a consortium of institutes led by MPE (Germany) and including UVIE (Austria); KU Leuven, CSL, IMEC (Belgium); CEA, LAM (France); MPIA (Germany); INAF-IFSI/OAA/OAP/OAT, LENS, SISSA (Italy); IAC (Spain). This development has been supported by the funding agencies BMVIT (Austria), ESA-PRODEX (Belgium), CEA/CNES (France), DLR (Germany), ASI/INAF (Italy), and CICYT/MCYT (Spain).

The SPIRE instrument contains an imaging photometer (camera) and an imaging spectrometer. The camera operates in three wavelength bands centred on 250, 350 and 500 µm, and so can make images of the sky simultaneously in three sub-millimetre colours; the spectrometer covers the wavelength range between 194 and 671 μm. SPIRE has been developed by a consortium of institutes led by Cardiff Univ. (UK) and including Univ. Lethbridge (Canada); NAOC (China); CEA, LAM (France); IFSI, Univ. Padua (Italy); IAC (Spain); Stockholm Observatory (Sweden); Imperial College London, RAL, UCL-MSSL, UKATC, Univ. Sussex (UK); Caltech, JPL, NHSC, Univ. Colorado (USA). This development has been supported by national funding agencies: CSA (Canada); NAOC (China); CEA, CNES, CNRS (France); ASI (Italy); MCINN (Spain); SNSB (Sweden); STFC and UKSA (UK); and NASA (USA).

The HIFI instrument is a very high-resolution heterodyne spectrometer and operates in seven bands covering the wavelength range between 157 and 625 µm. HIFI has been designed and built by a consortium of institutes and university departments across Europe, Canada, and the United States under the leadership of SRON Netherlands Institute for Space Research, the Netherlands, with major contributions from Germany, France, and the US. HIFI Consortium members are: CSA, U. Waterloo (Canada); CESR, LAB, LERMA, IRAM (France); KOSMA, MPIfR, MPS (Germany); NUI Maynooth (Ireland); ASI, IFSI-INAF, Osservatorio Astrofisico di Arcetri-INAF (Italy); SRON, TUD (Netherlands); CAMK, CBK (Poland); Observatorio Astronómico Nacional (IGN), Centro de Astrobiología (CSIC-INTA) (Spain); Chalmers University of Technology - MC2, RSS & GARD, Onsala Space Observatory, Swedish National Space Board, Stockholm University - Stockholm Observatory (Sweden); ETH Zurich, FHNW (Switzerland); Caltech, JPL, NHSC (USA).

CONTACTS

Thomas Passvogel

Herschel and Planck Programme Manager

ESA, The Netherlands

Email: Thomas.Passvogel esa.int

esa.int

Phone: +31-71-5655962

Herschel and Planck Programme Manager

ESA, The Netherlands

Email: Thomas.Passvogel

Phone: +31-71-5655962

Göran Pilbratt

Herschel Project Scientist

Research and Scientific Support Department

Science and Robotic Exploration Directorate

ESA, The Netherlands

Email: gpilbratt rssd.esa.int

rssd.esa.int

Phone: +31-71-5653621

Herschel Project Scientist

Research and Scientific Support Department

Science and Robotic Exploration Directorate

ESA, The Netherlands

Email: gpilbratt

Phone: +31-71-5653621

Matt Griffin

Principal Investigator of SPIRE

School of Physics and Astronomy

Cardiff University, UK

Email: Matt.Griffin astro.cf.ac.uk

astro.cf.ac.uk

Phone: +44-29-208-74203

Principal Investigator of SPIRE

School of Physics and Astronomy

Cardiff University, UK

Email: Matt.Griffin

Phone: +44-29-208-74203

Albrecht Poglitsch

Principal Investigator of PACS

Max-Planck-Institut für extraterrestrische Physik (MPE)

Garching, Germany

Email: alpog mpe.mpg.de

mpe.mpg.de

Phone: +49-89-30000-3293

Principal Investigator of PACS

Max-Planck-Institut für extraterrestrische Physik (MPE)

Garching, Germany

Email: alpog

Phone: +49-89-30000-3293

Frank Helmich

Principal Investigator for HIFI

SRON Netherlands Institute for Space Research

Groningen, The Netherlands

Email: F.P.Helmich sron.nl

sron.nl

Phone: +31-50-363-4799

Principal Investigator for HIFI

SRON Netherlands Institute for Space Research

Groningen, The Netherlands

Email: F.P.Helmich

Phone: +31-50-363-4799

Last Update: 29 Apr 2013

Source: ESA -

SCIENCE AND TECHNOLOGY , HERSCHEL

sábado, 27 de abril de 2013

Astrophysics > Cosmology and Extragalactic Astrophysics

Inflationary paradigm in trouble after Planck2013

(Submitted on 9 Apr 2013)

The recent Planck satellite combined with earlier results eliminate a wide spectrum of more complex inflationary models and favor models with a single scalar field, as reported in the analysis of the collaboration. More important, though, is that all the simplest inflaton models are disfavored by the data while the surviving models -- namely, those with plateau-like potentials -- are problematic. We discuss how the restriction to plateau-like models leads to three independent problems: it exacerbates both the initial conditions problem and the multiverse-unpredictability problem and it creates a new difficulty which we call the inflationary "unlikeliness problem." Finally, we comment on problems reconciling inflation with a standard model Higgs, as suggested by recent LHC results. In sum, we find that recent experimental data disfavors all the best-motivated inflationary scenarios and introduces new, serious difficulties that cut to the core of the inflationary paradigm. Forthcoming searches for B-modes, non-Gaussianity and new particles should be decisive.

| Subjects: | Cosmology and Extragalactic Astrophysics (astro-ph.CO); High Energy Physics - Phenomenology (hep-ph); High Energy Physics - Theory (hep-th) |

| Cite as: | arXiv:1304.2785 [astro-ph.CO] |

| (or arXiv:1304.2785v1 [astro-ph.CO] for this version) |

Download:

SOURCE:

myADS Personal Notification Service

Jorge Poveda

Sat Apr 27 02:51:57 2013

arXiv e-prints database

jueves, 25 de abril de 2013

|

Posted: 24 Apr 2013 10:14 AM PDT

Referencia: Physics.APS.org .

por Dietmar Plenz, 22 de abril 2013

Un modelo describe el cerebro como un sistema cerrado en una transición de fase, puede capturar la dinámica global de la actividad cerebral observada en los experimentos de resonancia magnética funcional.

- Imagen: (columna izquierda) experimentos de imagen de resonancia magnética funcional (fMRI) han revelado que el cerebro en reposo está organizado en varias áreas en las que se correlacionan las fluctuaciones de las actividades cerebrales, las así llamadas redes en estado de reposo (RSN). De arriba a abajo: visual Medial (VisM), visual lateral (VisL), auditiva (Aud) y sensorio-motor (SM) RSNs. (Columnas de la derecha) Resultados del trabajo de Haimovici et al. [1] que muestran que un modelo simple puede reproducir las propiedades estadísticas de las RSN sólo si el modelo está sintonizado con la criticidad (at TC).

Ya se están llevando a cabo proyectos pertinentes de investigación a gran escala o están siendo planificados a nivel internacional: elProyecto Humano Conectoma y BRAIN (Brain Research través Avanzando neurotecnologías innovadoras) en EE.UU., el proyecto Cerebro Humano en Europa, y el proyecto Brainnetome en China. El objetivo general de estas grandes empresas es la de explicar el funcionamiento del cerebro, mediante la adquisición e integración de una información detallada sobre la estructura del cerebro y su comportamiento dinámico.

Sin embargo, estos esfuerzos ¿tendrán éxito? El conocimiento de tan finos detalles estructurales del cerebro y las observaciones de las actividades neuronales puede no ser suficiente si la aparición de formas del comportamiento colectivo no se captura correctamente. Ariel Haimovichi, de la Universidad de Buenos Aires en Argentina, y sus compañeros de trabajo [1] escribe en Physical Review Letters, que el fenómeno cooperativo desempeña un papel clave en la determinación de la dinámica cerebral, al mostrar que el cerebro en su estado de reposo (es decir, cuando no está realizando una tarea explícita) es un sistema en criticidad.

Los sistemas críticos se pueden definir como sistemas que están cerca de un punto crítico, generalmente identificado como frontera de transición entre las fases de orden-desorden. Muchos sistemas complejos, lejos del equilibrio y composición de un gran número de elementos que interactúan han sido modelados con éxito como críticos: ejemplos notables de esto van desde las redes de interacción de genes hasta los mercados financieros.

En la criticidad, estos sistemas pueden evitar quedar atrapados en uno de dos casos extremos: un estado desordenado (cuando las interacciones son demasiado débiles y el sistema está dominado por el ruido) o un estado ordenado global en el que se bloquean todos los elementos (cuando las interacciones son demasiado fuertes y un sistema es completamente estático).

Ningún estado soporta el dualismo esencial de un sistema complejo como el cerebro para funcionar, debe mantener un cierto orden para garantizar un funcionamiento coherente (p. ej, generar un comportamiento reproducible en respuesta a un determinado estímulo) permitiendo al mismo tiempo un cierto grado de desorden que haga disponible la flexibilidad (o sea, adaptarse a las diferentes condiciones externas). En cambio, tal dualismo es posible gracias an la criticidad.

Aunque son posibles muchos grados de orden/desorden, el sutil equilibrio entre el orden y el desorden en la criticidad se manifiesta en ciertas propiedades estadísticas generales: Los sistemas críticos exhiben correlaciones espaciales y temporales que son de gran amplitud (es decir, en escalas que son más grandes que aquellas las que las interacciones mutuas tengan efecto) y seguir las distribuciones de la ley de potencias. Durante la última década, numerosos estudios han encontrado que el cerebro en reposo presenta muchas características propias de un estado crítico, como la escala de la ley de potencias de aludes neuronales (estallidos intermitentes de actividad eléctrica observados en la corteza cerebral) [2 y 3], correlaciones espaciales y temporales de largo alcance no evidentes de la actividad neuronal [4], y la ampliación anómala de las fluctuaciones de la actividad con el tamaño de la red [5]. La investigación llevada a cabo en mi grupo ha demostrado que las redes cerebrales, por estar en estado crítico, optimizan su respuesta a los entradas y maximizan su capacidad de procesamiento de información [6]. La principal conclusión de los autores es que la información estructural y las dinámicas neuronales locales tienen que integrarse en el marco de la criticidad para explicar la actividad cerebral. Dado que una de las señas de identidad de la criticidad es la invariancia de escala (la propiedad según la cual se observan similares dinámicas/propiedades en todas las escalas de longitud), su enfoque podría ser relevante para los diferentes niveles de la organización cerebral, que van desde pequeños microcircuitos corticales, a las columnas corticales hasta el cerebro completo, proporcionando de este modo un marco unificador para la interpretación de la acumulación de información sobre una estructura y dinámica neuronal. Si bien en el presente estudio los autores tuvieron que afinar su modelo para un determinado umbral de criticidad, el mayor desafío será entender cuáles son los mecanismos físicos y biológicos exactos por los que el cerebro llega a la criticidad y la mantiene durante el aprendizaje y el desarrollo. - Publicación: “Brain Organization into Resting State Networks Emerges at Criticality on a Model of the Human Connectome”. Ariel Haimovici, Enzo Tagliazucchi, Pablo Balenzuela, y Dante R. Chialvo. Phys. Rev. Lett. 110, 178101 (2013). Publicado el 22 de abril 2013, en PDF.

- Autor: Dietmar Plenz received his Ph.D. in Biology in 1993 at the Max Planck Institute of Biological Cybernetics, Germany. - Section on Critical Brain Dynamics, National Institute of Mental Health, NIH, Bethesda, MD 20892, USA

Fuente: Pedro Donaire, Bitnavegantes

|

miércoles, 24 de abril de 2013

|

Posted: 24 Apr 2013 03:40 AM PDT

Referencia: Kurzweilai.net, 23 de abril 2013

Mantenerse al día con la literatura científica actual es una tarea de gigantes, teniendo en cuenta que cada día se publican cientos de miles de documentos. Puestos a ello, los investigadores de la Universidad Estatal de Carolina del Norte han desarrollado un programa informático con capacidad de evaluar y clasificar los artículos científicos de campo. Los investigadores utilizan un algoritmo de minería de texto que dé prioridad a los trabajos de investigación para leer e incluir en su base de datos comparativa toxicogenómica (CTD), una base de datos pública mantenida y codificada de forma manual proveniente de los datos de la literatura científica, y que describe cómo los productos químicos ambientales interactúan con los genes que afectan a la salud humana. "Desde 1926, se han publicado sobre la toxicidad de metales pesados más de 33.000 artículos científicos", explica el Dr. Allan Peter Davis, gestor del proyecto de bioconservación CTD en la estatal de Carolina del Norte, que trabajó en el proyecto y es co-autor principal de un artículo sobre este trabajo. "Simplemente no podemos leer y codificarlo todo. Y, con la ayuda de este nuevo algoritmo, ya no tenemos que hacerlo." Para ayudar a seleccionar los artículos más relevantes para su inclusión en el CTD, Thomas Wiegers, investigador bioinformático de la NC State y otro co-autor principal del informe, desarrollaron un sofisticado algoritmo como parte de un proceso de minería de textos. La aplicación evalúa el texto entre miles de trabajos y asigna una puntuación de relevancia a cada documento. "Esta clasificación al conjunto de artículos ayuda a separar el grano de la paja, por así decirlo," dice Wiegers. Pero, ¿en qué medida un algoritmo puede determinar los mejores trabajos? Para probar esto, los investigadores de extrajeron texto de 15.000 artículos y enviaron una muestra representativa a su equipo de bioconservadores para leer manualmente y evaluarlos por sí mismos, sin saber nada de la puntuación asignada. "Los resultados fueron impresionantes", comenta Davis. Los bioconservadores estuvieron de acuerdo con el algoritmo en un 85 por ciento de las veces respecto a los documentos más puntuados. Utilizar el algoritmo para clasificar documentos permitió a los bioconservadores centrarse en los trabajos más relevantes, aumentando la productividad en un 27 por ciento y en contenidos novedosos en un 100 por ciento. "Es un tremendo paso para ahorrar tiempo", explica Davis. "Con esto podemos distribuir nuestros recursos de manera mucho más efectiva haciendo que el equipo se centre en los documentos más informativos." Siempre hay valores atípicos en este tipo de experimentos: puede ocurrir que el algoritmo asigne una puntuación muy alta a un artículo que el bioconservador humano descarte rápidamente como irrelevante. El equipo que analizó los valores extremos a menudo fue capaz de ver un patrón en el por qué el algoritmo identificaba erróneamente un determinado documento como importante. "Ahora podemos volver atrás y modificar el algoritmo para dar cuenta de eso y afinar el sistema", dice Wiegers. "No estamos aún en ese punto en que un equipo pueda leer y extraer todos los datos relevantes por sí mismo", concluye Davis, "pero si con este proceso de minería de texto nos dirigirnos hacia los artículos más informativos es un gran primer paso. " Este trabajo fue apoyado por el Instituto Nacional de Ciencias de Salud Ambiental. - Imagen: CTD minería de texto, crédito:. Allan Peter Davis et al / PLoS ONE - Referencias: Allan Peter Davis et al., Text Mining Effectively Scores and Ranks the Literature for Improving Chemical-Gene-Disease Curation at the Comparative Toxicogenomics Database, PLoS ONE, 2013, DOI: 10.1371/journal.pone.0058201 (open access).

Fuente: Pedro Donaire. Bitnavegantes.

|

lunes, 22 de abril de 2013

|

Posted: 21 Apr 2013 09:37 PM PDT

Referencia: Physics.APS.org .

por Don Monroe, 19 abril 2013

Los sistemas dinámicos que maximizan sus posibilidades futuras se comportan de maneras sorprendentemente "inteligentes". La segunda ley de la termodinámica, la que dice que la entropía sólo puede aumentar, dicta que un sistema complejo siempre evoluciona hacia un mayor desorden en la forma en que sus componentes internos se organizan. En Physical Review Letters, dos investigadores exploran una extensión matemática de este principio que no se centra en la disposición que el sistema alcance en este momento, pero en la que alcanzará en el futuro. Ellos argumentan que los simples sistemas mecánicos que se postulan para seguir esta regla muestran características de "inteligencia", haciendo alusión a una conexión entre este atributo tan humano y las leyes fundamentales de la física. La entropía mide el número de disposiciones internas de un sistema que dan como resultado el mismo aspecto exterior. La entropía aumenta debido a que, por razones estadísticas, un sistema evoluciona hacia estados que tienen muchas disposiciones internas. Una variable de una investigación previa, ha proporcionado "un muchas pistas sobre que hay algún tipo de asociación entre la inteligencia y la maximización de la entropía", señala Alex Wissner-Gross, de la Universidad de Harvard y el Instituto Tecnológico de Massachusetts (MIT). A una escala más grande, por ejemplo, los teóricos sostienen que la elección de posibles universos que crean la mayor entropía favorable a los modelos cosmológicos son los que permiten el surgimiento de observadores inteligentes [ref. 1]. Con la esperanza de concretar tales ideas, Wissner-Gross formó equipo con Cameron Freer, de la Universidad de Hawaii, en Manoa, para proponer una "entropía de ruta causal." Esta entropía no se basa en las disposiciones internas accesibles de un sistema en cualquier momento, sino en el número disposiciones que podría atravesar en su camino hacia posibles estados futuros. Ellos calculan entonces, una "fuerza entrópica causal" que empuja al sistema a evolucionar con el fin de aumentar esta entropía modificada. Esta hipotética fuerza es análoga a la presión que ejerce un compartimiento lleno de gas, sobre el pistón que lo separa de un compartimiento casi vacío. En este ejemplo, la fuerza aumenta porque el movimiento del pistón incrementa la entropía del compartimiento lleno más de lo que reduce la del que está casi vacío. En contraste con la usual entropía, no hay ninguna ley fundamental conocida que estipule que esta apariencia futura de la fuerza entrópica rija como va a evolucionar un sistema. Pero, como en un experimento mental, los investigadores simularon el comportamiento de unos simples sistemas mecánicos que incluían la fuerza, y los efectos fueron profundos. Por ejemplo, una partícula errante en una caja no explora el volumen al azar, sino que encuentra su camino hacia el centro, donde va a estar mejor posicionada para moverse hacia cualquier parte de la caja. Otra simulación hizo el seguimiento del movimiento de un péndulo rígido que cuelga de un pivote y se balanceaba horizontalmente. El péndulo eventualmente se movía hacia una configuración invertida, la cual es inestable sin la fuerza entrópica modificada. Desde esta posición invertida, argumentan los investigadores, el péndulo puede explorar con mayor facilidad todas las demás posiciones posibles. Los investigadores interpretaron este y otros comportamientos como indicadores de una inteligencia adaptativa rudimentaria, donde los sistemas se movían hacia configuraciones que maximizaban su capacidad de responder a los cambios. Wissner-Gross reconoce que "no hay un acuerdo general sobre la definición de lo que realmente es la inteligencia", pero apunta que los científicos sociales han especulado sobre ciertas habilidades que prosperaron durante la evolución, ya que éstas permitieron a los humanos explotar las oportunidades ecológicas. En ese sentido, los investigadores conectan la invertida "versatilidad" mecánica del péndulo con las habilidades que los bípedos, como nosotros, requieren a fin de crear numerosos ajustes sobre la marcha, necesarios para mantener el equilibrio mientras se camina. Wissner-Gross y Freer simularon otras tareas ideadas para imitar las pruebas de inteligencia estándar con animales. Emularon "el uso de herramientas" con un modelo en el que un gran disco podía tener acceso a otro disco atrapado, golpeándolo con un tercer disco. Otra de las tareas, la "cooperación social", requería dos discos para coordinar sus movimientos. En ambos casos, la respuesta simulada a la fuerza entrópica modificada conseguía estos objetivos sin ninguna orientación adicional. Estos dos comportamientos, junto con el lenguaje gramatical dirigido, que dice Wissner-Gross que también ha replicado, han sido invocados por Stephen Pinker, de la Universidad de Harvard, como característica del "nicho cognitivo" humano. "Nos quedamos muy sorprendidos por todo esto", comentó Wissner- Gross. Anteriormente, los científicos informáticos han utilizado una versión de la entropía causal para guiar los algoritmos que se adaptan a una información continuamente actualizada. La nueva formulación no está destinada a ser un modelo literal del desarrollo de la inteligencia, sino que apunta hacia un "panorama general termodinámico de lo que es el comportamiento inteligente", señala Wissner-Gross. El documento ofrece una "intrigante nueva visión sobre la física de la inteligencia", coincide Max Tegmark, del MIT, que no participó en el trabajo. "Es impresionante ver que un comportamiento sofisticado surge espontáneamente de un proceso físico tan simple." - Ref. [1]: R. Bousso, R. Harnik, GD Kribs y G. Pérez, "Predicción de la constante cosmológica desde el principio entrópico causal", Phys.. Rev. D 76, 043513 (2007) . - Publicación: "Causal Entropic Forces". A. D. Wissner-Gross and C. E. Freer. Phys. Rev. Lett. 110, 168702 (2013). Published April 19, 2013

Fuente: Pedro Donaire, Bitnavegantes

|

sábado, 20 de abril de 2013

Astrophysics > Cosmology and Extragalactic Astrophysics

What have we learned from observational cosmology ?

(Submitted on 16 Apr 2013)

We review the observational foundations of the ΛCDM model, considered by most cosmologists as the standard model of cosmology.

The Cosmological Principle, a key assumption of the model is shown to be verified with increasing accuracy. The fact that the Universe seems to have expanded from and hot and dense past is supported by many independent probes (galaxy redshifts, Cosmic Microwave Background, Big-Bang Nucleosynthesis and reionization).

The explosion of detailed observations in the last few decades has allowed for precise measurements of the cosmological parameters within Friedman-Lemaitre-Robertson-Walker cosmologies leading to the ΛCDM model: an apparently flat Universe, dominated by a cosmological constant, whose matter component is dominantly dark.

We describe and discuss the various observational probes that led to this conclusion and conclude that the ΛCDM model, although leaving a number of open questions concerning the deep nature of the constituents of the Universe, provides the best theoretical framework to explain the observations.

| Comments: | 23 pages, no figure. Proceedings of "Philosophical Aspects of Modern Cosmology" held in Granada, Spain, 22-23 Sept. 2011. Studies in History and Philosophy of Modern Physics (2013) |

| Subjects: | Cosmology and Extragalactic Astrophysics (astro-ph.CO); History and Philosophy of Physics (physics.hist-ph) |

| DOI: | 10.1016/j.shpsb.2013.02.002 |

| Cite as: | arXiv:1304.4446 [astro-ph.CO] |

Download:

SOURCE:

| (or arXiv:1304.4446v1 [astro-ph.CO] for this version)arXiv.org > astro-ph > arXiv:1304.4446

Note: Λ reads Lambda

|

sábado, 13 de abril de 2013

|

Posted: 12 Apr 2013 04:33 AM PDT

Referencia: ThunderBolts.info .

por Stephen Smith, 9 de abril 2013

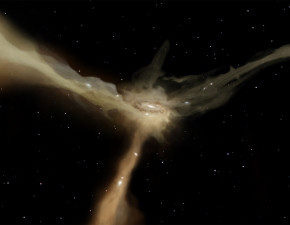

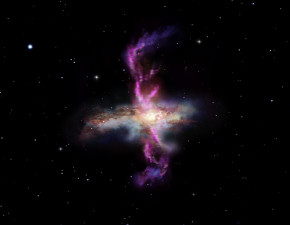

Los campos magnéticos galácticos fueron descubiertos hace más de 50 años. Pero los astrónomos continúan haciéndose preguntas básicas acerca de las galaxias: ¿Qué genera los campos magnéticos? ¿Qué da a los campos su forma y su fuerza? Los investigadores que utilizan las simulaciones informáticas más avanzadas creen haber encontrado la respuesta. Dicen que el gas frío que cae dentro de las galaxias, las explosiones de supernovas, el nacimiento de nuevas estrellas y la energía de rotación de dichas galaxias son los que crean los campos. Sin embargo, faltan otros factores en sus ecuaciones, ya que los modelos no son capaces de predecir los campos observados en varias galaxias espirales representativas. ¿Cómo observan los científicos extrasolares los campos magnéticos? George Ellery Hale representa primero el campo magnético del Sol a través del "efecto Zeeman", o el cambio de posición de las líneas de Fraunhofer que se encuentran en los espectrogramas del Sol. El espectro óptico indica qué productos químicos se pueden encontrar en el Sol, así como en otras estrellas. Mediante la descomposición de la luz de la estrella en sus componentes, igual que hace un prisma con la luz blanca, las líneas oscuras en lugares específicos proporcionan una forma de determinar los elementos constitutivos de una estrella. En presencia de un campo magnético, los elementos producen líneas espectrales que se dividen y ocupan diferentes posiciones. Estos cambios de posición se conocen como el efecto Zeeman. No son de extrañar que esos contornos del campo magnético que rodean a las estrellas, así como los observados alrededor de las galaxias, sigan sin explicación en las mentes de aquellos que sostienen el punto de vista convencional. En la piscina teorética del conocimiento que ellos dibujan, no existen entidades eléctricas que proporcionen la fuente para que el magnetismo. En cambio, se discuten "la formación de estrellas reductora de la energía turbulenta", las "eyecciones de gas" y "la rápida aparición de campos magnéticos que surgen de forma aleatoria". En sus cálculos no se incluye el electromagnetismo, ni los campos eléctricos ni los efectos moto-generadores. Los campos magnéticos en el espacio pueden ser detectados más fácilmente que las corrientes eléctricas, así que los astrónomos modernos piensan que los campos son fragmentos "primordiales" dejados ahí por el Big Bang. Ellos confían en la conclusión que explica cómo se formaron las estructuras que componen el Universo. El hecho de que estas cargas en movimiento constituyen una corriente eléctrica que pueden generar campos magnéticos se conoce desde los días de Michael Faraday; sin embargo, la falta de conocimiento a menudo significa falta de visión. Como se ha indicado anteriormente, el movimiento de las partículas cargadas constituye una corriente eléctrica, y que la corriente está envuelta en un campo magnético. Cuanto más se aceleran las partículas cargadas en la misma dirección, más fuerte se hace el campo. Esto es una noción muy conocida por los ingenieros eléctricos, pero cuando los astrónomos encuentran cargas en movimiento en el espacio se quedan desconcertados y se refieren a ellos como "vientos" u "ondas de choque". Otra cosa no considerada cuando los investigadores tratan de explicar la estructura del Universo, es que las partículas cargadas se mueven, deben moverse en un circuito. Los eventos energéticos no se puede explicar solamente por las condiciones locales, deben ser considerados los efectos de un circuito completo. Por esta razón, mientras que en su visión del mundo el consenso científico sólo permite solitarias "islas" de espacio, el Universo Eléctrico enfatiza la conectividad con una red eléctricamente activa de "líneas de transmisión" compuestas por filamentos de corrientes de Birkeland. Los filamentos se expanden y explotan, expulsando el plasma que puede acelerarse a cerca de velocidad de la luz. Los chorros van desde los polos opuestos de un extremo galaxia en nubes energéticas que emiten frecuencias de rayos X. Estos fenómenos están basados en la ciencia del plasma y no en la cinética de los gases, la gravedad, ni en la física de partículas. Los astrofísicos ven los campos magnéticos, pero no la electricidad subyacente, por lo que se encuentran perdidos a la hora de explicarlo. Los astrónomos sostienen que las galaxias son nubes del gas hidrógeno y de polvo intergaláctico que fueron reunidos por la gravedad hasta fusionarse en brillantes fuegos termonucleares. La comunidad convencional propone también que, la mayoría de las galaxias contienen agujeros negros de magnitud increíble. Son esas "fuentes puntuales gravitacionales" las que causan el giro de las galaxias, chorros de rayos gamma y de rayos X que abarcan miles de años luz hasta que aparecen, algo así como "lóbulos de radio" a veces más grandes que la misma galaxia donde se forma. La teoría del Universo Eléctrico no se adhiere a esta idea condensación de hidrógeno frío e inerte y de partículas de circón no más grandes que una molécula. Así pues, ¿Qué son las galaxias? En 1981, Hannes Alfvén, dijo que las galaxias se parecen mucho a uno de los inventos Michael Faraday, el motor homopolar. Un motor homopolar se mueve por los campos magnéticos inducidos en una placa circular conductora. Esta placa está montada entre los polos de un electroimán, causando que gire a una velocidad proporcional a la corriente de entrada. Las galaxias se mueven dentro de un filamentoso circuito de electricidad que fluye a través de todo el cosmos, de principio a fin. Nosotros vemos los efectos de esos campos electromagnéticos que permean el espacio. La electricidad se organiza dentro de masas de plasma, a veces más grandes que los cúmulos galácticos. Ese plasma está compuesto principalmente de átomos neutros, aunque también están presentes los electrones libres, protones y otras partículas cargadas. Energía eléctrica primordial es de varios órdenes de magnitud más poderosa que la gravedad. Las "cuerdas de plasma" que comprenden las corrientes de Birkeland se atraen entre sí en la distancia, en una relación lineal, por lo que las corrientes de Birkeland son la fuerza atractiva de largo alcance más poderosa del Universo. Las corrientes eléctricas fluyen a través del plasma de polvo manteniendo los campos magnéticos detectados en las estrellas y galaxias. - Imagen: Tres galaxias interactuando: NGC 7173 (centro izquierda), NGC 7174 (centro derecha) y NGC 7176 (abajo derecha). Crédito: NASA, ESA, y R. Sharples (Universidad de Durham)

Fuente Pedro Donaire, BITNAVEGANTES

|

|

Posted: 06 Apr 2013 02:44 AM PDT

Referencia: Science.Dailey.com, 4 abril 2013

Un biólogo, en el Colegio de Medicina de Universidad estatal de Florida, ha hecho nuevos descubrimientos que nos acercan un paso más cerca de entender cómo apareció la vida por primera vez en la Tierra hace miles de millones de años. El profesor Michael Blaber y su equipo extrajeron datos que apoyan la idea de que existen en la Tierra 10 aminoácidos que hace alrededor de 4 mil millones de años fueron capaces de formar proteínas plegables en un entorno muy salino (halófilo). Tales proteínas habría sido capaces de proporcionar la actividad metabólica necesaria para que emergieran los primeros organismos vivos del planeta hace entre 3,5 y 3,9 mil millones años. Los resultados del estudio de tres años de Blaber, fueron construidos en torno a unas técnicas de investigación que tardaron más de 17 años en poder desarrollarse, y que ahora publican en Proceedings of the National Academy of Sciences. Los primeros organismos vivos habrían sido microscópicos, organizaciones similares a células capaces de replicarse y adaptarse a las condiciones ambientales, un humilde comienzo para la vida en la Tierra. "El paradigma actual del surgimiento de la vida es que el ARN fue lo primero en un ambiente de altas temperaturas", dijo Blaber. "Pero los datos que hemos generado están mucho más a favor de un surgimiento primario de proteínas en un ambiente halófilo". La opinión ampliamente aceptada entre los científicos es que el ARN, que se encuentra en todas las células vivas, representaría probablemente a las primeras moléculas de la vida, se trata de la hipótesis de un "ARN primario" en el origen de los sistemas vivos desde las moléculas no vivas. Lo hallazgos de Blaber indican que, el conjunto de aminoácidos producidos por sencillos procesos químicos, contienen la información necesaria para producir complejas proteínas plegadas, que soportan el punto de vista opuesto de una "proteína-primaria". Otro punto de vista importante, sostiene que en un ambiente de altas temperaturas (termófilo), como las chimeneas termales del océano profundo, pudo haber sido el caldo de cultivo para el origen de la vida. "El medio ambiente halófilo, ha sido tradicionalmente considerado como una vida adaptada, pero no iniciadora", señaló Blaber. "Aunque nuestro estudio de los aminoácidos y proteínas prebióticas sugiere lo contrario." Sin la capacidad de plegarse, las proteínas no serían capaces de formar las estructuras esenciales precisas que mantienen las funciones de la vida tal como la conocemos. El plegamiento permite que las proteínas adquieran una forma globular a través de la cual pueden interactuar con otras proteínas, llevando a cabo reacciones químicas específicas y adaptándose para que los organismos exploten un entorno determinado. "Hay numerosos nichos en los que la vida puede evolucionar", añadió Blaber. "Por ejemplo, los extremófilos son microorganismos que viven en altas temperaturas, en alta acidez, frío extremo, presiones extremas y sal extrema, y así sucesivamente. Para que exista la vida en tales entornos, es esencial que las proteínas sean capaces de adaptarse a dichas condiciones. En otro palabras, deben que ser capaces de plegarse." Los fragmentos de cometas y meteoritos, como los que recientemente han golpeado la región de los Urales en Rusia, han aportado pruebas sobre la llegada de aminoácidos a la Tierra. Estos fragmentos son anteriores a la Tierra y podrían haber sido responsables de la entrega de un conjunto de 10 aminoácidos prebióticos, cuyos orígenes se encuentran en la formación de nuestro sistema solar. Hoy en día el cuerpo humano utiliza 20 aminoácidos comunes para fabricar todas sus proteínas. Diez de ellos surgen a través de las rutas biosintéticas, otros diez -el conjunto prebiótico-, puede obtenerse por reacciones químicas sin requerir de ningún sistema vivo o vía biosintética. Existen evidencias científicas que apoyan muchos elementos de las teorías de la abiogénesis (el surgimiento de la vida), incluyendo el período de tiempo (alrededor de 3,5 a 3,9 mil millones años atrás), y las condiciones de la Tierra y en su atmósfera en esa época. La Tierra se habría formado por masas de tierra volcánica (el comienzo de la formación de los continentes), océanos salados y lagunas de agua dulce, además de agua caliente (a unos 80 ºC) y un ambiente repleto de vapor que contenía dióxido de carbono y nitrógeno. El oxígeno llegaría más tarde, como subproducto vital de las plantas verdes y las bacterias que surgieron. Usando un método de análisis llamado top-down (de arriba-abajo) de deconstrucción simétrica, el laboratorio de Blaber ha sido capaz de identificar pequeños bloques de construcción de péptidos capaces de un ensamblaje espontáneo en arquitecturas de proteínas específicas y complejas. Su reciente trabajo ha explorado si dichos bloques de construcción pueden estar compuestos de tan sólo 10 aminoácidos prebióticos e incluso plegados. Su equipo ha logrado proteínas plagadas de hasta 12 aminoácidos, lo que conforma el 80 por ciento del camino para probar su hipótesis. Si la teoría de Blaber se sostiene, supondría reorientar la búsqueda de evidencias sobre el cómo empezó la vida. "Más que un curioso nicho donde la vida evolucionó, el medio ambiente halófilo ahora puede pasar a ser el centro del escenario como localización probable de aspectos clave para la abiogénesis", concluyó. "De igual modo, el papel de la formación de proteínas adquiere una importancia adicional en los primeros pasos de la vida sobre la Tierra." - Imagen: Costa del Mar Muerto. Crédito: © frag / Fotolia. - Fuente: Florida State University, via Newswise. - Publicación: L. M. Longo, J. Lee, M. Blaber. Simplified protein design biased for prebiotic amino acids yields a foldable, halophilic protein. Proceedings of the National Academy of Sciences, 2013; 110 (6): 2135 DOI: 10.1073/pnas.1219530110.

Fuente : Pedro Donaire, Bitnavegantes

|

Etiquetas:

Abiogenesis,

Ambiente Halofilo.,

Aparicion Vida Terrestre

Suscribirse a:

Comentarios (Atom)